L’intelligence artificielle (IA) est devenue un acteur incontournable dans le domaine de la médecine. Des diagnostics assistés par des algorithmes aux robots chirurgiens, l’IA promet une révolution dans le soin des patients. Pourtant, cette avancée technologique soulève des questions éthiques profondes. Quelles sont les implications d’intégrer l’IA dans nos systèmes de santé ? Quels défis éthiques se posent alors que des machines prennent des décisions qui affectent la vie humaine ? Cet article explore ces enjeux cruciaux.

Les promesses de l’IA en médecine

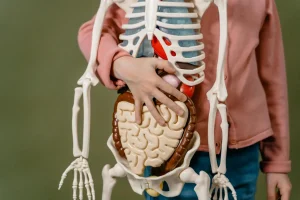

Avant d’aborder les défis éthiques, il est essentiel de comprendre ce que l’intelligence artificielle peut apporter au secteur médical. Elle permet d’optimiser les traitements, d’améliorer les diagnostics, et même de prédire certaines maladies. Par exemple, des algorithmes d’apprentissage automatique peuvent analyser des milliers d’images médicales en un temps record, identifiant des anomalies que l’œil humain pourrait négliger.

Considérons une étude récente : une IA a réussi à détecter des signes précoces du cancer du sein avec une précision supérieure à celle des radiologues expérimentés. Ces résultats soulèvent une question fascinante : l’IA peut-elle surpasser l’intuition humaine dans des domaines aussi sensibles que la santé ?

Les enjeux éthiques de l’IA en médecine

Malgré ses avantages, l’intégration de l’IA dans le secteur médical comporte des risques éthiques. À qui incombe la responsabilité en cas d’erreur ? Qu’en est-il de la confidentialité des données des patients ? Voici quelques-uns des défis majeurs.

1. La responsabilité des décisions médicales

Lorsque l’IA prend des décisions, la question de la responsabilité devient floue. Si un diagnostic erroné est posé par un algorithme, qui est responsable ? Le médecin qui a fait confiance à l’IA ? Les développeurs de l’algorithme ? Ou l’institution qui a intégré cette technologie dans son système ? L’absence de clarté sur ce point peut avoir des conséquences graves.

2. La confidentialité des données

Un autre défi majeur réside dans la protection des données. Les systèmes d’IA nécessitent de vastes quantités de données pour apprendre et s’améliorer. Cela pose des questions sur la manière dont ces données sont collectées, stockées et utilisées. Les patients doivent-ils craindre que leurs informations médicales soient compromises ou utilisées à des fins non éthiques ?

3. La discrimination algorithmique

Un aspect souvent négligé est le risque de biais dans les systèmes d’IA. Si les données utilisées pour entraîner un algorithme sont biaisées, les résultats le seront également. Par exemple, si une IA est formée principalement sur des données d’un groupe démographique spécifique, elle pourrait ne pas être efficace pour d’autres populations. Cela soulève des inquiétudes quant à l’équité des soins de santé : existe-t-il un risque que certaines populations soient désavantagées ?

La confiance des patients dans l’IA

La confiance est cruciale dans toute relation médicale. Les patients doivent avoir confiance non seulement en leurs médecins, mais aussi dans les technologies qui les assistent. Cependant, l’introduction de l’IA peut susciter des doutes. Les patients peuvent se demander si un algorithme peut vraiment comprendre leur situation mieux qu’un médecin humain. Comment créer un cadre où le patient se sent à l’aise avec l’utilisation de telles technologies ?

Un exemple concret : Imaginez un patient, Paul, qui après des mois d’examens et de consultations, se retrouve face à un diagnostic d’IA. Bien que ce diagnostic soit précis, Paul peut ressentir une certaine appréhension. Sa santé est entre les mains d’un algorithme, et il se demande si ce dernier a pris en compte tous les aspects de son état médical. Cela illustre la nécessité d’une communication claire et ouverte entre les professionnels de santé et leurs patients.

Vers une utilisation éthique de l’IA en médecine

Il est essentiel de développer un cadre éthique pour l’utilisation de l’IA en médecine. Plusieurs pistes peuvent être explorées :

- Encadrement juridique : Élaborer des lois et des règlements clairs concernant la responsabilité des décisions prises par l’IA.

- Transparence des algorithmes : Les systèmes d’IA doivent être transparents. Les patients et les praticiens doivent comprendre comment et pourquoi une décision a été prise.

- Formation des professionnels de santé : Les médecins et les soignants doivent être formés pour travailler en synergie avec l’IA, afin de tirer le meilleur parti de ces outils tout en restant vigilants quant à leurs limites.

- Engagement du public : Impliquer les patients dans le processus de développement des technologies afin de s’assurer que leurs préoccupations soient prises en compte.

Les effets futurs sur la pratique médicale

Alors, quelles seront les implications à long terme de l’IA en médecine ? La technologie évolue rapidement, et il est difficile de prédire l’avenir avec certitude. Cependant, il est possible d’envisager plusieurs scénarios. L’IA pourrait permettre une médecine plus personnalisée, où les traitements seraient adaptés à chaque patient. Cela pourrait révolutionner la façon dont les maladies sont traitées.

D’un autre côté, une dépendance excessive à l’IA pourrait conduire à une déshumanisation des soins. Les médecins pourraient devenir trop prompts à se fier aux algorithmes, perdant de vue l’importance de l’empathie et de la relation humaine dans la guérison.

Il est donc crucial de trouver un équilibre. La technologie doit servir de complément à l’expertise humaine, et non de substitut. Cela nécessitera une réflexion continue sur la manière dont l’IA peut être utilisée de manière éthique et bénéfique pour tous.